Aktualitások

A pénzügyekben is új időszámítást hozhat a kvantumszámítógép

Az úgynevezett kvantumszámítás témája egyre népszerűbb, és úgy tűnik, hogy a tudományos közösség és a pénzügyi befektetők is nagy reményeket fűznek a jövőjéhez. Minden jel arra utal, hogy ez a vadonatúj technológia forradalmasítja a jelenleg ismert számítástechnika különböző vetületeit. Az orvostudománytól az egészségügyön, a mesterséges intelligencián, az információkezelésen, -titkosításon, -továbbításon és -tároláson át a pénzügyi befektetésekig jelentős előnyök származhatnak az alkalmazásából, és olyan távlatokat nyit, amik korábban nem voltak elképzelhetők, így végső soron a tudásunkat gazdagítja és hozzájárul a világ fejlődéséhez. Az ügy horderejét mutatja, hogy technológiai cégek, kormányok évről-évre több milliárd dollárt fordítanak a kvantumszámítógépek fejlesztését célzó kutatások előmozdítására.

SZERZŐ:

VÁGÓ ATTILA, CONCORDE

A kvantumszámítógépek nem a klasszikus számítógépek kiterjesztései, hanem teljesen új típusú konstrukciók. A kvantumszámítógépek a természet fizikai jelenségeit használják fel az információk kvantummechanika segítségével történő manipulálására. Működési elvük és absztrakt elméleti hátterük felfogása nem csak a fizika terén kevésbé jártasak számára jelent nehézséget, de a témát elmélyülten tanulmányozó kutatókat is időről-időre zavarba ejti. Már a kvantummechanika fogalmi rendszerének elsajátítása is komoly fejfájást okoz, nem beszélve a mögöttes matematikai struktúra (pl. a komplex számtest felett értelmezett Hilbert-tér) megértéséről. A helyzetet pedig csak rontja, hogy nincs olyan reprezentáció, amely klasszikus analógiával vezetne be a kvantummechanikán alapuló információtárolást, feldolgozást és továbbítást felölelő kvantuminformatikába.

Bár a kvantummechanika feneketlen mélysége még tartogat rejtelmeket, de ahhoz legalább hozzá lehet szokni, hogy egyre több szó esik róla. A jelen írásunk első része a kvantumszámítógépek néhány alkalmazási lehetőségére mutat rá a pénzügyek területén, míg a második rész rövid, de annál tömörebb betekintést nyújt a kvantumszámítógépek elméleti háttérbe.

Pénzügyi alkalmazás

A pénzügyi szolgáltatások iparága előretekintően mindig is arra törekedett, hogy az új technológiákat kihasználja a jövedelmezőség javításának érdekében. Ez a szemlélet vezette például Henry Goldman bankárt, a Goldman Sachs társalapítóját is, aki a kvantummechanikai kutatások közismerten bőkezű patrónusa volt. Az új technológiák adaptációja és a pénzügyi szolgáltatások fejlődése a digitális jövő felé vezető fázisokon követhető nyomon. Az első hullám a mobileszközök használatára összpontosított az ügyfelek megszerzése és megtartása érdekében. Ezt követte az új üzleti modellek feltárása az új adatforrások kihasználása és a technológiai (fintech) szolgáltatók felől jövő fenyegetések elhárítása érdekében. A jelenlegi harmadik hullámot számos kihívás vezérli, beleértve a bevételek maximalizálását, a költségmegtakarítási kényszert, a szaporodó kibertámadások szembeni hatékony védelem megteremtését, a gyakori és nem egyszer a jövedelmezőség rovására menő szabályozási változásokhoz való rugalmas alkalmazkodást, valamint (biztosítóknál) a nem tervezett kockázatok, például természeti katasztrófák vagy piaci összeomlás miatt felmerülő addicionális tőkeigények kezelését. Mindezek a kihívások arra késztetik a pénzintézeteket, hogy alapjaiban definiálják újra működési modelljeiket és külső szerepvállalásukat.

A pénzügyi szolgáltatások területén (úgymint vagyonkezelés, befektetési banki tevékenység, lakossági és vállalati banki tevékenység, kockázatkezelés, biztosítások) számos erőpróbát jelentő számítási probléma van, amelyek amellett, hogy megkövetelik a pontosságot, roppantul időigényesek. Ezeket alapvetően három nagyobb osztályba lehet sorolni:

- Optimalizálási problémák, amelyek exponenciális léptékűek, ami korlátozza megoldhatóságukat egy adott időkereten belül. A kvantumszámítógépek optimalizálási problémáinak holisztikus problémamegoldó megközelítése felveti annak lehetőségét, hogy kevesebb lépésben jobb megoldásokat találjunk.

- Úgynevezett machine learning problémák, ahol összetett adatstruktúrákkal kell dolgozni, amelyek akadályozzák az osztályozás vagy az előrejelzés pontosságát. A kvantumszámítógépek többdimenziós adatmodellező képessége viszont lehetővé teheti, hogy egyre pontosabb mintákat találjunk, amik rövidebb idő alatt vezethetnek megoldáshoz.

- Szimulációs problémák, ahol ugyancsak időkorlát van a megfelelő forgatókönyv-teszt elvégzésére és a legjobb lehetséges megoldás megtalálásához. A kvantumszámítógépeket kihasználó hatékony mintavételi módszerek kevesebb mintát igényelhetnek a pontosabb megoldás gyorsabb eléréséhez.

Portfoliókezelés: A kvantumszámítógépek használata a kockázatkezelés és a befektetési portfóliók optimalizálásának területén idővel minden bizonnyal kulcsfontosságúvá és megkerülhetetlenné válik, mivel a kvantumszámítógépek véges idő alatt képesek bonyolult optimalizációs feladatokat megoldani, amikkel közönséges számítógépek feltehetően sohase birkóznak meg.

Nagy elemszámú befektetési portfólió optimalizálása során egyszerűen túl sok lehetőség van a számítógép számára a leghatékonyabb portfólió kiválasztásához (legmagasabb hozam, legkisebb kockázatvállalás és tőkekorlát mellett), ami nyilvánvalóan rengeteg számítási időt igényel (akár több napot is). Egy százelemű portfólió esetén például a lehetséges elempárosítások száma kettő a századikon, ami egy bődületesen nagy szám. Így ahelyett, hogy minden egyes lehetőséget figyelembe vennénk, vagyis a befektetési portfólió kialakításához választható eszközök minden részhalmazát egyenként vizsgálnánk meg a klasszikus számítógépeken is lefuttatható úgynevezett Monte Carlo (MC) algoritmusok segítségével, a kvantumszámítógépeken az optimalizálási, gépi tanulási és szimulációs problémák megoldásához használt kvantumalgoritmusok más megközelítést alkalmaznak a többdimenziós tereken keresztül. Ezeknek az algoritmusoknak köszönhetően a számítási idő négyzetesen felgyorsul. Az idő pedig mint tudjuk pénz. Akik az összetett pénzügyi eszközöket nagyobb pontossággal tudják árazni, versenyelőnyre tehetnek szert.

Kockázatkezelés: A pénzintézetek számára a legfőbb próbatételt az eszközök és kötelezettségek lejárati struktúrájának összehangolása, a kamatláb- és partnerkockázat kiküszöbölése jelenti, miközben a likviditással, csalással, pénzmosással vagy nemteljesítő hitelekkel (NPL) kapcsolatos fenyegetéseket is kezelni kell. A bázeli egyezmények megkövetelik a bankoktól, hogy a kockázattal súlyozott eszközeik nagyságához mérten bizonyos összegű tőkét tartsanak fenn, vagy hogy a likviditás fedezeti rátájuk (LCR) megfelelő értékű legyen. Nem vitás, a tőkekövetelmények és a likviditás pontos meghatározása elemi érdeke a bankoknak. A pontosabb modellekkel rendelkező bankok elméletileg hatékonyabban tudják hasznosítani a tőkéjüket. Számos pénzügyi eszköz árazása és kockázatának becslése azonban számításigényes. Ráadásul az analitikai modellek gyakran túlontúl leegyszerűsítettek ahhoz, hogy megragadják a pénzügyi eszközök közötti összetett függőségi viszonyokat, vagy nem vesznek figyelembe egyes jellemzőket, például az úgynevezett útvonalfüggést (egy opció értéke attól függően változhat, hogy az alapul szolgáló eszköz árfolyama milyen pályát ír le az opció élettartama alatt, vagy az élettartama során bizonyos időszakokban). A VaR (a kockáztatott érték), a veszteségeloszlás kvantilisa (a várható legnagyobb veszteség), például egy széles körben használt kockázati mérőszám.

A Basel III szabályozás előírja a bankoknak, hogy stresszteszteket végezzenek VaR és CVaR meghatározásához, amihez nagyon gyakran MC-szimulációkat alkalmaznak. Ennek során a kockázatkezelési modellek kiszámítják a veszteség/nyereség eloszlását a modell bemeneti paramétereinek számos különböző realizációjára. A veszteség/nyereség eloszlás reprezentatív eloszlásának eléréséhez persze rengetegszer szükséges elvégezni (lefuttatni) a számításokat. Egy MC-szimulációban valamekorra számú mintát vesznek a modell bemeneti eloszlásaiból, és felhasználják az érdeklődésre számot tartó kimenetelek becslésére. A Monte Carlo szimuláció több értéket használ, majd átlagolja az eredményeket. Egy ilyen becslés rendkívül számításigényes. Például előfordulhat, hogy a konfidencia intervallum méretének egy nagyságrenddel való csökkentése a számítási igény sokszorosának növelését teszi szükségessé. A kvantumszámítógép ismételt futtatásával és a kimenet ismételt mérésével nagy valószínűséggel meghatározhatjuk a helyes eredményt, olyan módon, hogy a lekérdezett kimeneti eredmények közül a gyakoribbat fogadjuk el. Az AE algoritmus például négyzetes gyorsítást biztosít a klasszikus MC-szimulációkhoz képest, ezáltal pedig hatékonyabb becslésre is vezet. Az úgynevezett Grover algoritmus pedig nagy, rendezetlen adatbázisban valósít meg keresést rendkívül gyorsan.

Opciók és egyéb pénzügyi derivatívák: Az pénzügyi derivatívák értékének meghatározására szolgáló paraméterek sztochasztikus jellege miatt a derivatívák valós értékének kiszámítása nehézkes feladat. A legegyszerűbb opciótípusokra például léteznek analitikai modellek, de a zárt formájú megoldásokhoz szükséges piaci dinamikára vonatkozó egyszerűsítő feltételezések gyakran korlátozzák alkalmazhatóságukat. Ezért az opcióárazáshoz leggyakrabban numerikus MC szimulációkat alkalmaznak, mivel ezek rugalmasak és általánosan képesek kezelni a sztochasztikus paramétereket. Az MC-szimuláción alapuló opciós árazás általában a mögöttes eszközök árfolyamának időbeli alakulását számos kimeneti lehetőség (pálya) mentén szimulálja ahhoz, hogy az opció lehetséges lejárati kifizetési függvényértékeinek eloszlását modellezze. Az opció árát ezután ezen eloszlás várható értékének diszkontálásával kapjuk meg. A klasszikus MC szimulációs módszerek kiterjedt számítási erőforrásokat igényelnek az opciók árának pontos becsléséhez, különösen összetett opciók esetében.

Az opciók és egyéb pénzügyi derivatívák értékének pontos kiszámítására a kvantumszámítógépek idővel jobban megfelelhetnek, mint a hagyományos számítógépek. Egy kvantumszámítógép számára szükséges megoldási idő ugyanis a kimenetelek (megvizsgálandó válasz) számának (n) négyzetgyökével lesz arányos, míg egy klasszikus számítógépnek (n + 1)/2 próbálkozás szükséges a válasz megtalálásához, ha minden egyes lehetséges válasz megvizsgálása ugyanannyi időt vesz igénybe. A kvantumszámítógép tehát bizonyos problémák megoldásának idejét akár évekről töredék időre csökkentheti.

A misztikus kvantumvilág

Gordon Moore 1965-ben publikálta nagyhatású és máig érvényes elméletét arról, hogy integrált áramkörben költséghatékonyan (legalacsonyabb áron) beépített tranzisztorok száma nagyjából másfél évente megduplázódik (Moore-törvény.) Ezzel párhuzamosan folyamatos méretcsökkenés is megfigyelhető, ami, ha így folytatódik, oda vezethet, hogy egy bitnyi információt egy atomban fogunk tudni tárolni. Ilyen mérettartományban azonban már a kvantummechanika törvényei érvényesek.

A kvantum név abból a megfigyelésből származik, hogy bizonyos fizikai tulajdonságok egységnyi mennyiségenként (latin: kvantum), nem pedig folyamatos (analóg) módon változnak. Ami egy hagyományos mérési skálán folyamatosnak tűnik, ahogy finomítjuk a mérést, kiderül, hogy valójában lépcsőzetesen, ugrásszerűen (kvantumonként) változik. Az atomi világban kvantáltság van, azaz vannak olyan kicsi mennyiségek, amelyeknél apróbbak már elvileg nem léteznek, és amelyeknek a tulajdonságait már nem lehet a Newton-féle mechanikával megmagyarázni (például az elektron viselkedését az atomban).

A kvantummechanika megértésének nehézségét az okozza, hogy a newtoni fizikához szokott hétköznapi szemléletünk nehezen tud idomulni az atomok és azoknál kisebb részecskék viselkedésének magyarázatához. Míg a newtoni mechanika arra keresi a választ, hogy egy adott t időpontban a test milyen állapotban van, hol található, milyen sebességgel mozog (a newtoni fizikában az objektumok valahol vannak, a helyük, pályájuk meghatározott), addig a kvantumvilágban létezik többféleség és folyamatos bizonytalanság van a tekintetben, hogy valami hol van. A kvantummechanika azt vizsgálja, hogy milyen valószínűséggel van egy vizsgált részecske egy adott állapotban (például adott helyen). Az elektronnak például nem egy egyértelműen meghatározott helye van. Az elektron tulajdonképpen egy térben eloszló komplex függvény, amihez egy bizonyos sűrűségeloszlás rendelendő, és ahol ez a függvény elég sűrű, ott inkább észlelhető a jelenléte, mint ott, ahol ez a függvény „lecseng”, vagyis a részecske kitérése kis valószínűséggel lesz nagy. (A természet leírásához komplex számokra is szükségünk van.) Sajnos ezúttal a térbeli sűrűség sem feltétlenül az, amit elsőre gondolnánk, nem valaminek valószínűségekkel történő felbukkanása egy adott helyen vagy máshol. Az elektronhoz nem egy pálya vagy konkrét hely van hozzárendelve, ami alapján detektálható lenne, hanem valami, ami a térben eloszlik, azaz előfordulhat olyan, hogy egyszerre jelen van többfelé és nincsen egy hajszálpontosan meghatározható helyen. Ugyanígy a fény elemi részecskéjéről, a fotonról is be tudták már bizonyítani, hogy képes egyszerre két helyen lenni.

Mindez valószínűleg rettenetesen bonyolultan hangzik, és igencsak erős képzelőerő szükségeltetik valami olyan absztrakt viselkedést felismerni a természetben, ami a hagyományos szemléletünkbe nem illeszthető be, ami például egyszerre lehet hamis és igaz is. Az ember legtöbbször furcsán áll a mikrovilágban uralkodó törvényszerűségek hétköznapi szemlélet számára meghökkentő idegenszerűsége előtt. Csak az létezik, ami kézzelfogható, észlelhető, amire bizonyíték van. Tudom, hogy most a számítógépen előtt ülök. A számítógép létezik. Ugyanakkor, nem látjuk, de bizonyított, hogy van levegő, amit beszívunk. Ugyanez igaz az elektromosságra. Nem látjuk, de érzékeljük a hatását. Van úgy, hogy két ember egyszerre gondol ugyanarra a dologra és egyszerre mond ki azonos szavakat. Nem mondhatjuk, hogy nem fordulhat elő ilyen, hiszen van rá precedens, de az oka egzaktul aligha magyarázható. Nem csoda, hogy a tudósok végül arra jutottak, hogy léteznie kell egy makro- és mellette egy mikrovilágnak. De hogy csavarjunk egyet a dolgon, egyre nagyobb, akár még csillagászati méretű objektumokra is vélhetőleg igazolható, hogy érvényes rájuk a kvantumelmélet. Így aztán meglehetősen csábító az a feltevés, hogy valójában szükségtelen két külön elmélet: a newtoni fizika része lehet egy sokkal általánosabb elgondolásnak, ami a kvantumelmélet.

Qubitok szuperpozícióban

Minden számítástechnikai rendszer az információ tárolásának és kezelésének alapvető képességére támaszkodik. A (kvantum)információ alapegysége a kvantumszámítógépekben a kvantumbit („qubit”). Egy kvantumszámítógép a qubitek sorozatát kezeli és ehhez kvantumjelenségeket használ. Ellentétben a klasszikus, kétféle állapoton (0 és 1 biten) alapuló elektronikus számítógépektől (a bit továbbított információ digitális formában megjelenített alapegysége), a qubit nem csak 0 (hamis) vagy 1 (igaz) értéket vehet fel kizárólag, hanem a kettő valószínűségi jellegű kombinációját is egyszerre, vagyis valamekkora eséllyel előfordulhat az állapotok összetett értékkel súlyozott kombinációjában, ami így végtelen számú állapotot tesz lehetővé. Egy qubit egy időben felvehet például 20 százalék eséllyel 0 és 80 százalék eséllyel 1 értéket, ami viszont csak méréskor derül ki. Addig csak valószínűségek léteznek az egyes eredményekre, az egyes qubitek állapotára. Ezt a (valószínűségi alapú) kvantumállapotot szuperpozíciónak nevezzük a kvantummechanikában. A szuperpozíció jelenségéről leegyszerűsítve tehát azt lehet mondani, hogy a részecskék egyszerre több kevert (azaz nem egy bizonyos) állapotban fordulnak elő.

A kvantumszámítógépben a kvantumbiteket tehát a klasszikusan megengedett állapotok szuperpozíciójával adhatjuk meg. A szuperpozíció viszont rendkívül instabil, és csak addig marad fenn, amíg a kvantum állapotát megmérjük. Amikor ki szeretnénk olvasni belőlük az értéket, összeesnek, és a végén 0 vagy 1 értéket vesznek fel. Ezt a folyamatot érdemes úgy elképzelni, mint egy vektort, ami az egységkör egy pontjára mutat. Viszont mi csak az x és az y tengelyeken tudjuk észlelni őket. Tehát amint megmérjük a vektort, odaugrik valamelyik közeli tengelyhez, és oda fog mutatni.

A kvantuminformatikában a Hilbert-tér kétdimenziós altere érdekes a számunkra. Ebben a kétdimenziós altérben választott bázis egymásra merőleges és egységnyi hosszúságú vektorait tekintjük a bit 0 és 1 értékének. (A bázis a lineáris algebrában egy vektorhalmazt jelent, melynek vektorainak lineáris kombinációja adja egy megadott vektortér összes vektorát, és ezen vektorhalmaz egyik vektora sem fejezhető ki a többi elem lineáris kombinációjával.) Mivel a vektortér lineáris, ezért egy kétállapotú fizikai objektum nem csak 0 és 1 állapotok valamelyikében lehet, hanem ezeknek tetszőleges komplex számokkal képzett lineáris kombinációjában is, azaz olyan összegként, melyben a bázisvektorok többszörösei (itt skalárszorosai) szereplenek. Ez a már említett szuperpozíció.

Csipetnyi matek

Vegyük azt a példát, hogy ez a vektor egy 30 fokos szöggel mutatna az x = √3/2; y = 1/2 pontra, akkor mérés után 3/4 eséllyel mérnénk az x tengelyen (mondjuk 0-nak) és 1/4 eséllyel az y tengelyen (mondjuk 1-nek). Ha mindezt lerajzoljuk, akkor látható, hogy a pont háromszor messzebb van az y tengelytől, mint az x-től. Viszont x+y nem ad ki 1-et, pedig azt várnánk, hogy az összes lehetséges eset összes esélyének összege 1 legyen (azaz teljes eseményrendszert alkossanak). Azt azonban láttuk, hogy az egységkörön lévő pont távolsága a tengelyektől 3/4 (y tengelytől) és 1/4 (x tengelytől). A megoldás tehát, hogy a tengelyen mért értékek négyzetét kell vennünk, ha a valószínűségeiket szeretnénk megkapni. Általánosítva: az összes lehetséges állapothoz tartozó együttható abszolút értékének négyzetösszege egyet kell, hogy adjon, hiszen a részecskének (objektumnak) biztosan lennie kell valamilyen állapotban. Mivel a qubiteknek fázisuk is lehet, ezért az előbbi egységkörös történetet térben kell elhelyeznünk. Lesz egy egységgömbünk, de a mérés logikája nem fog változni.

Ami számunkra itt a lényeg, hogy a szuperpozíciónak köszönhetően nagyságrendekkel több adat tárolására adnak lehetőségek a qubitek, mint a bitek. Míg n számú biten tárolhatunk egy kiválasztott (mondjuk 0 és 10 közötti) intervallumban lévő egész számot, addig n qubiten egyszerre tárolhatjuk az összes számot 0 és 10 között.

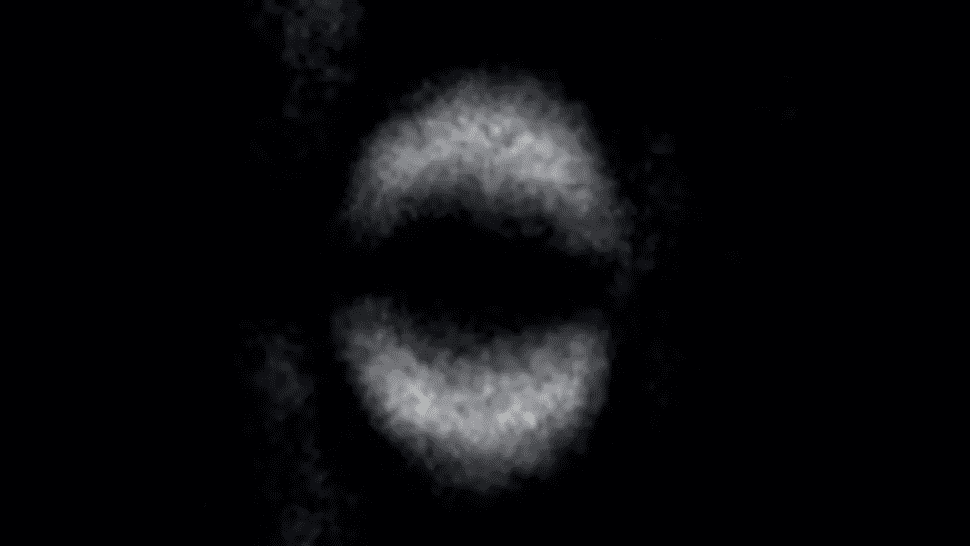

Képfelvétel a kvantum összefonódásról

(forrás: Livescience)

Kiderült, hogy a természet nem írható le lokális változókkal. A kvantummechanika működik, bár filozófiai alapjai még kiforratlanok. Mi itt lakonikusan csak annyit jegyzünk meg, hogy atomi szinten a részecskék nem úgy viselkednek, mint a „nagy” tárgyak, amelyekkel a mindennapi életben találkozunk.

Szupravezetés

Köztudomású, hogy az anyagok ellenállása függ a hőmérséklettől. Minél kisebb a hőmérséklet, annál kisebb az ellenállás. Ennek a jelenségnek (a higany esetében) történt felfedezésért a holland Heike Kamerlingh Onnes 1913-ban Nobel-díjat kapott. Az ellenállás abszolút nulla fokhoz közelítve eltűnik. Gyakorlatilag minden fém és bizonyos vegyületek esetében is megfigyelhető az a tulajdonság, hogy alacsony hőmérsékleten elektromos ellenállásuk nullává válik, azaz ellenállás nélkül vezetik az áramot. Ez a szupravezetésnek nevezett fizikai jelenség (kvantummechanikai effektus) akkor következik be, ha a hőmérséklet egy kritikus érték alá csökken, amely tipikusan kevesebb, mint -260°C (magyarán közel abszolút nulla fokra hűtött anyagoknál jön létre). A szupravezetőkben nulla ellenállás esetén (amíg tehát a megfelelően alacsony hőmérséklet fennáll) az elektromos áram végtelen ideig fennmarad (nem szűnik meg). Elméletileg, még 0 Kelvin (K) hőmérsékleten is vannak ugyanis egy fémnek olyan elektronjai, amelyek energiája nem nulla, és amelyek mindig mozognak. A kvantumszámítógépekben koaxiális kábelek a vezetékek, amik szupravezető tulajdonságúak.

A szupravezetés kvantummechanikai elméletét 1957-ben alkották meg amerikai fizikusok: John Bardeen, Leon N. Cooper és John R. Schrieffer, amiért 1972-ben fizikai Nobel-díjat kaptak. Tulajdonképpen a Cooper-párok viselkedésének megismerése vezetett a későbbiekben olyan alkalmazási lehetőségekre, mint a szupravezető nanoszerkezeteken alapuló kvantumszámítógépek lehetőségének felvetése. A szupravezetők új szintre emelték a számítástechnikát, mert energiaveszteség és túlmelegedés nélkül lehet belőlük építeni nagyon gyors elektronikai rendszereket.

Nyúlfarknyi fizika

Megfelelően alacsony hőmérsékleten az elektronok közötti vonzó hatás erősebb, mint az elektromos taszítás. Amikor a hőmérséklet elér egy kritikus (átmeneti) pontot (hívhatjuk küszöbhőmérsékletnek is) egy szilárdtestben, egy újfajta kölcsönhatás lép fel az elektronok között, köztük kötőerő jön létre és egy párrá kapcsolódnak össze. Ezeket a kötött elektron párokat hívjuk Cooper-pároknak. A Cooper-párok létrejötte tulajdonképpen a szupravezetés jelensége. Szupravezetéskor az áramot a Cooper-párok vezetik. A folyamat lényege, hogy a küszöbhőmérseklet elérése hatást gyakorol a fémrács pozitív ionjaira és a szabad elektronokra nézve is. Elektronpár-képződéskor valamelyik szabad elektron az ionráccsal való kölcsönhatás során kibocsát egy virtuális fonont (kvantált rugalmas hullámot vagy rácsrezgést), amelyet egy másik szabad elektron elnyel. A két elektron közötti fononcsere pedig vonzóerőt eredményez, amely képes legyőzni a közöttük ható elektrosztatikus taszítóerőt.

Egy qubitekből álló kvantumszámítógépben elengedhetetlen, hogy egymástól távoli qubitek között összefonódás létrejöjjön. A szupravezetők az összefonódás természetes bázisai, mert alapállapotukban az elektronok összefonódott Cooper-párokat alkotnak. Alapállapotnak hívjuk a legalacsonyabb energiájú állapotot, amiben leegyszerűsítve minden nyugalomban van. Abszolút nulla fokon (0 Kelvin) minden rendszer alapállapotba kerül.

Ahhoz, hogy a Cooper-párok qubitek közötti összefonódás létrehozására alkalmasak legyenek, először térben szét kell választani őket. A szétválasztást megvalósító áramkör a Cooper-pár szétválasztó. A Cooper-párok külön elektronokra való felosztását (felhasadását) az elektronok Coulomb-taszítás révén lehet kikényszeríteni.

Brian David Josephson angol fizikus 1962-ben megjósolta, hogy két szupravezető elektród között áram képes folyni akkor is, ha a kettő szupravezetőt egy vékony réteg szigetelővel (oxidréteggel) vagy nem szupravezető fémes anyagból készült réteggel választanak el. Ezt a jelenséget Josephson-effektusnak nevezik, aminek felfedésért Josephsont Nobel-díjjal jutalmazták 1973-ban. Egy ilyen interferencia eszközben (interferencia: két vagy több hullám szuperpozíciója eredményeként létrejövő új hullám mintázat) az elektronok a szigetelőanyagon keresztül az egyik anyagról a másikra áramolhatnak még külső feszültség hiányában is. Ilyenkor az elektronok Cooper-párokként haladnak át az érintkezési ponton (kontaktus) egy a geometriától, a hőmérséklettől és a mágneses mezőtől függő kritikus értékig. Jóllehet Cooper-párok nem létezhetnek szigetelőkben, ha a két szupravezetőt elválasztó réteg elég vékony, „átalagutazhatnak” rajta, miközben megtartják fázisuk koherenciáját a tér két különböző pontjában.

A klasszikus mechanika és a kvantummechanika különbözőképpen kezeli ezt a helyzetet. A klasszikus mechanikában egy részecske nem tud áthaladni egy gáton, ha nincs hozzá elég energiája, arról visszaverődik. Kvantummechanikában viszont létezik az a jelenség, amit alagúthatásnak hívunk, amikor is a részecskék (pl. összeérintett fémek között) képesek áthatolni (áramolni) úgynevezett potenciálgátakon (ami lehet a fémek felületén kialakuló oxidréteg), de ehhez az kell, hogy a potenciálgát kellőképpen vékony legyen a terjedés irányában. Szemléletesebben, ha egy részecske nem rendelkezhet elég energiával a potenciálfal “áthágásához”, akkor alatta “alagúton” juthat át a túloldalra. Alagúthatás esetében részecskék képesek áthatolni olyan gátakon, melyeken a logika szerint elvileg nem lehetséges. Ennek értelmezéséhez feltételezni kell az anyag kettős természetét, ugyanis a részecskék hullámfüggvény-formalizmusában az effektus leírható. A kvantummechanika egyik központi alapvetése, hogy minden objektumnak van hullám- és részecske-természete is (a fény és az anyag is mutat mind hullám-, mind részecsketulajdonságokat), bár ez a jelenség csak nagyon kis skálán, például az atomokén érzékelhető.

Leküzdendő kihívások

A számítástechnika kvantumforradalma (a paradigmaváltás) még várat magára. A kvantumbitek roppant kicsi, mikroszkopikus részecskék, kezelésük komoly kihívás elé állítja a szakembereket. Az IBM legnagyobb szupravezető kvantumprocesszora, az Eagle 127 qubittel rendelkezik, ami még közel sem éri el azt a qubit-számot, amennyi a legtöbb forradalmi ötlet megvalósításához (számítási probléma megoldásához) elengedhetetlen.

A kvantumszámítógépek rendeltetésszerű működéséhez szükséges megfelelő külső hőmérséklet biztosítása ugyancsak nehéz feladat. A Google kutatói által 2019-re elkészített kvantumszámítógép vákuumos, -273 °C alatti kamrában, pillanatnyilag 53 kvantumbittel működik. A rendkívül alacsony hőmérsékleti körülményeket (olyan hideget, mint a világűr) a kvantummechanikai hatások miatt szükséges folyamatosan biztosítani, ami korántsem egyszerű feladat. Enélkül azonban a kvantumszámítógépek nem tudnak a rendeltetésüknek megfelelően működni. Az IBM és a Google erőfeszítéseiben közös, hogy mindkettő cég szupravezető áramkörökből akar kvantumszámítógépet építeni.

További probléma, hogy a zajt is valahogy ki kell zárni, vagyis teljesen zajmentes környezet szükséges a kvantumszámítógépek működtetéséhez. A qubitek ugyanis rendkívül zajérzékenyek. A zaj alatt kvantumos méretű effektusokat kell értenünk. Ha valamilyen finom részecske a qubit közelébe jut (mint például egy szabad szemmel nem is látható fényű infravörös foton) vagy valamilyen hanghatás éri a kvantumszámítógépet, akkor a qubit elveszíti a tervezett működését, könnyen hibát vét és nem kívánatos számítási eredményre jut. Mérnöki szempontból tehát egy olyan rendszert kell létrehozni, amely gyakorlatilag mindentől elszigetelt. Képesnek kell lennünk arra, hogy kikapcsoljuk a kvantumbitek és a mérés közötti csatolást, hogy kvantumbiteket ne “oltódjnak ki”, miközben műveleteket végzünk velük. Egy számítás a kvantumszámítógépen túl sokáig sem tarthat.

Az úgynevezett kvantum előny (Quantum Advantage) azt a bizonyított és mért sikert jelenti, hogy kvantumszámítógépen gyorsabban lehet feldolgozni egy valós problémát, mint egy klasszikus számítógépen. Mivel a kvantumfeldolgozó egységek (QPU-k) még nem skálázhatók eléggé ahhoz, hogy a valós világban felmerülő nagyobb problémákat megoldják, évek telhetnek el, mire valódi kvantumelőnyhöz jutunk. Egyelőre nincs olyan végső univerzális architektúra, amely bármilyen számítási problémát meg tudna oldani. Egy adott probléma kiszámításához (megoldásához) a részecskék összefonódását a kvantumgépek jelenleg csak korlátozott módon tudják lehetővé tenni.

Összegzés

Az erős hardvereik miatt a hagyományos számítógépek rengeteg számítást tudnak elvégezni másodpercek alatt és hallatlan sebességgel jelenítik meg az információkat olyan mindennapokban használt eszközökön, mint az okostelefonok, laptopok vagy a felhőben lévő szerverek, de például a képfelismerés, természetes nyelvek, gépi tanulás és az optimalizációs problémák területén gyengén teljesítenek. A kvantumszámítógének (qubiteknek) megvan az kellemes tulajdonságuk, hogy másfajta számítási módot tesznek lehetővé, miáltal a hagyományos problémákat új (vagyis más) módon és így gyorsabban oldhatjuk meg rajtuk. A kvantum-összefonódás révén a kvantumszámítógépek képesek arra, hogy a számítási feladatokat párhuzamosan végezzék el, ezáltal lényegesen nagyobb hatékonysággal és gyorsabban működnek. Ezen tulajdonságuk révén másodpercek tört része alatt lehet velük például titkosításokat feltörni vagy optimalizációs problémák végére jutni. A kvantumjelenségeket kihasználó számítógépek úgy próbálják tervezni, hogy képesek legyenek megoldani jelenleg még megoldhatatlan kalkulációs problémákat, amelyek vagy rendkívül nagyok vagy időigényesek és „felrobbannak” a számítás során. Olyan alkalmazási lehetőségeket rejtenek magukba, ami a klasszikus algoritmusokkal egyszerűen képtelenség megvalósítani. Az amplitúdó becslő kvantum-AE például segíthet a bankoknak és biztosítóknak a kockázati mutatók becslésében, a pénzügyi eszközök árazásában vagy a stressztesztekben használható forgatókönyv-elemzések elvégzésében, tekintettel az általuk elérhető kifinomultabb kockázatelemzésre, dinamikus ügyfélkezelésre, a piaci volatilitás, a tranzakciók gyorsabb és folyamatos követésére.

Jóllehet a kvantuminformatika még gyerekcipőben jár, a kvantumalgoritmusok futtatásához többféle architektúra, specifikáció is ismert már: például elektromágneses csapdában tartott részecskék révén megvalósuló megoldások közé az ioncsapdás, az atomcsapdás, illetve az elektroncsapdás kvantumszámítógépek tartoznak, ahol például optikai és/vagy mágneses tér segítségével irányítják az ionokat, és ahol a csapdában levő részecske állapotai alapján definiálhatóak a qubitek, de alkalmaznak speciális tranzisztorokat, szupravezető áramköröket vagy például nanogömböket, amelyek fényként viselkednek.

A kvantumszámítógépek fejlesztése több irányban zajlik. Az úgynevezett adiabatikus kvantumszámítógépek a kvantummechanikai alagúteffektust kihasználva nyújthatnak nagy segítséget bizonyos klasszikusan lehetetlen analitikus feladatok megoldásában. A mágneses rezonancián alapuló NMR kvantumszámítógép (Nuclear Magnetic Resonance Quantum Computers) a gyógyszerkészítés területén hozhat sikereket. Az optikai kvantumszámítógép a fotonok és optikai kapuk segítségével történő megvalósításokat támogathatja például a véletlenszám generálás területén. A genfi illetőségű ID Quantique cég már évek óta foglalkozik kvantumoptikára épülő valódi véletlenszám generátorok készítésével, amelyet a kriptográfia területén, a szerencsejáték-iparban, vagy épp a számítógépes játékoknál is alkalmazhatóak. A hibatűrő univerzális kvantumszámítógépek (FTQC) kifejlesztése szintén folyamatban van. Megépítésük lehetővé teszi tetszőleges kvantum-algoritmusok alkalmazását olyan elmélettel alátámasztva, amely bizonyítja a kvantumgyorsulást a klasszikus algoritmusokhoz képest.

Szeretnék rendszeresen értesülni a friss tartalmakról